最近上线的中国AI软件DeepSeek引发业界震撼,开发商声称建构DeepSeek的基础成本很低,仅是OpenAI的零头,最广为流传的说法之一,是DeepSeek V3的训练成本约为600万美元。不过这个说法被半导业行业研究公司SemiAnalysis质疑,他们认为DeepSeek的成本应该至少13亿美元。

有趣的工程(Interesting Engineering)报导,SemiAnalysis指出,它未能解释几个关键因素。600万美元的估算,只考虑了GPU预训练费用,忽略了公司在研发、基础设施和其他必要成本方面的大量投资。报告强调,DeepSeek的总服务器资本支出,就高达13亿美元。

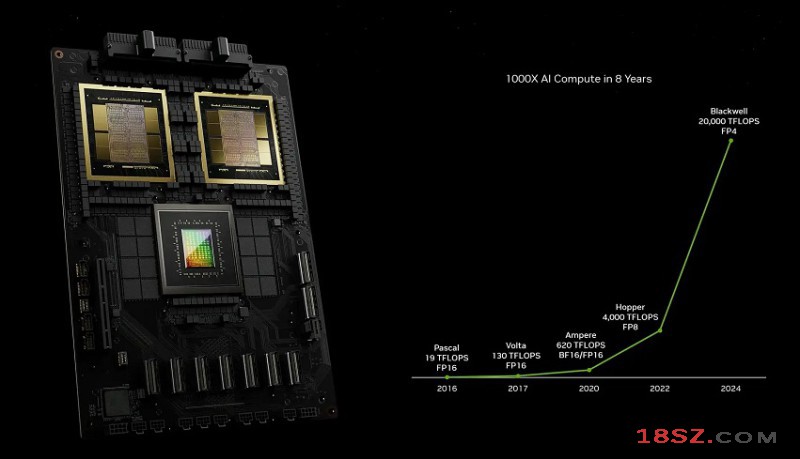

根据报导,DeepSeek使用了大约5万张Hopper GPU(微构架的),这导致业界产生了一些误解。以为这就等于5万张辉达H100 GPU(Nvidia Hopper H100 GPU)。

SemiAnalysis澄清说,英伟达的GPU有多种型号,包括H800、H100以及NVIDIA为应对美国出口限制而生产的H20。也是中国可以获得的类型。

该报告称,与一些较大的人工智能实验室不同,DeepSeek数据中心采用精简模型,来提高其灵活性和效率。这算是一种不错的调节能力,分析显示DeepSeek的R1模型,表现出与OpenAI的o1相当的推理能力。然而,这不意味着DeepSeek在所有指标都性能领先。

虽然DeepSeek的定价策略引起了关注和赞誉,但有一个重要的警告:功能相似的Google Gemini Flash 2.0,在API服务存取时更加经济。这使得DeepSeek处于一个十字路口,平衡性能和成本是其未来成功的关键。

但是,DeepSeek的多头潜在注意力(Multi-Head Latent Attention,MLA),是个颇具突破性的创新,这种方法透过减少键值(KV)缓存的使用,显著降低了93.3%的推理成本。不过,DeepSeek 带来的创新,也很可能会被渴望保持竞争力的西方人工智慧实验室迅速采用。

报告推测,DeepSeek可能产生不错的竞争环境,令其他同行也必须具有更快的调节能力。总之,SemiAnalysis描绘了DeepSeek在AI领域的当前地位。它的成本结构、GPU利用率,和创新能力,确实成为一名强大的AI参与者。