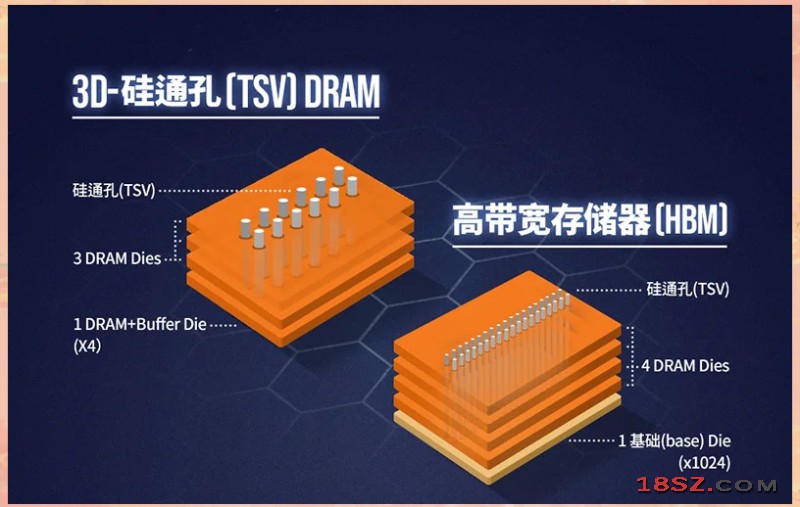

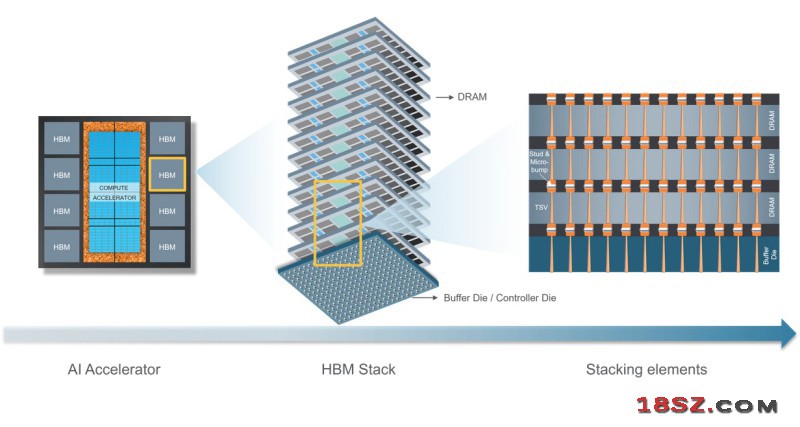

为了提供人工智能应用所需的大量內存,芯片制造商已转向高带宽内存(HBM)——一种由先进DRAM堆叠构建的高效能、低延迟构架。虽然DRAM 芯片的创新很重要,但HBM的高密度和高频宽其实是透过先进的3D 封装实现的。如今生成式AI驱动下,高带宽内存(HBM)定制化,已成为新焦点。受频宽、容量、能效及成本效益的需求推动,市场逐步从标准化解决方案,转向更灵活的定制化方案。

研调机构Counterpoint Research预期,2026年HBM4的推出,将进一步扩大定制化HBM市场。NVIDIA、亚马逊、微软、博通及Marvell等大厂正积极推动定制化HBM方案,主要分为两大路线,分别是HBM直接封装至SoC,省略基底晶片(base Die)与中介层(Interposer),降低成本并扩展I/O数量,但在扩展容量与散热管理上面临挑战。

另一是优化base Die,以提升效能,透过增加逻辑功能提升记忆体效能与稳定性,提供更实用的性能增强方案。定制化HBM的发展,不仅关乎架构设计,更围绕数据传输效率创新,包括通讯IP:提升GPU 与HBM之间的数据传输效率,包括控制器、物理层(PHY)与介面技术。

光子技术:透过光讯号取代电子讯号,提高传输速率并降低延迟,尽管仍面临技术与成本挑战。快取记忆体技术:降低DRAM错误率,提升系统稳定性。

根据Marvell预测,定制化运算市场在资料中心的占比,将从2023年的16%,成长至2028年的25%。部分记忆体业者则预估,到2030年,定制化HBM将占整体HBM市场的30~40%。然而,尽管定制化HBM提供更高效能,企业仍偏好标准化方案以控制成本。

Counterpoint Research指出,定制化HBM虽具备突破性潜力,但市场仍须在效能提升与实际应用之间找到平衡。随著技术成熟,未来 HBM标准演进仍存变数,类似于1990年代Rambus的授权模式,如何在创新与成本竞争间寻求最佳方案,将是记忆体业者面临的关键课题。